CXL联盟董事成员 / CXL联盟

为了进一步推广并维护这一标准,CXL联盟诞生了。从2019年到现在,该联盟已经拥有了180多家成员公司,董事成员也都是全球顶尖大厂。那么这一标准究竟解决了什么问题,CXL 2.0标准又带来了哪些改变,以及CXL后续的路线图如何呢?

CXL解决的问题

CXL的出现解决了现有计算架构中,尤其是在数据中心里亟待解决的内存问题。首先就是内存与XPU捆绑在一起,比如CPU、GPU和DPU,他们的容量大小完全取决于XPU的支持,且无论加多少单DIMM内存还是双DIMM内存,其带宽容量都不会改变。

CXL扩展内存 2.0 / 三星

CXL的出现为带来了CXL扩展内存这一产品形态,这些扩展内存不仅提高了最大内存容量,也进一步提升了内存带宽。以三星在今年5月推出的CXL扩展内存 2.0为例,这一DRAM内存容量高达512GB,是上一代的四倍。根据三星的说法,该内存用到了三星自研的ASIC CXL控制器,系统延迟也是上一代的四分之一。

CXL 2.0带来的改变

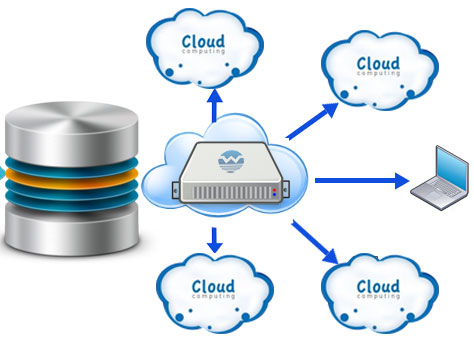

CXL 1.1解决了内存扩展的问题,而CXL 2.0引入的资源共享技术,让不同XPU之间实现内存共享成为可能。CXL 2.0中新增了CXL交换与多逻辑设备功能,如此一来每个主机都能用到他们所需的内存,而且可以动态分配。如此一来,不仅解决了系统中DRAM没有得到充分利用的问题,也让内存的扩展不再只跟着XPU走。这一技术再加上内存扩展,意味着CXL与主内存之间共享大型内存池可以将服务器内存提升至数十TB,内存带宽也会因此提升至数TB/s。

CXL资源共享和交换 / Marvell

还有就是服务器场景中常见的热插拔,为了灵活地使用硬件资源,拥有多个主机、交换机和设备的大型系统时不时需要连接和断开这些资源。如果每次添加新设备都得断臂整个系统的话,可能会连带影响到服务器上运行的各种业务。

而热插拔在过去的PCIe中都是可选功能,而在CXL 2.0引入交换和Fabric管理后,CXL支持了热插入和受管理的热拔出。热插入只是对PCIe 5.0规范中定义的方法进行了些许修改,但热拔出却必须要使用软件请求才能实现,否则可能会影响到内存和CXL的缓存一致性。

一窥CXL 3.0

随着现有网络结构的发展,越来越多的用例需要用到更高的带宽,无论是GPU这类高性能加速器,还是系统内存,又或是DPU和SmartNIC,但随着这类硬件的核心数量增加,每个核心所用带宽却是在减小的,而CXL 2.0目前带宽不一定能满足未来的需求。其次用到的互联技术要能够做到先进的交换、高效的对等网络和精确的资源共享,才能优化这些组件在多个域上的系统级流程。而基于PCIe 6.0的CXL 3.0提供了成倍的带宽,进一步提升了互联的性能。

此外,CXL 3.0在扩展性和资源调用上也将进一步提升。比如内存共享将获得进一步加强,并支持全新的内存使用模型,同时多主机下的多层级交换将进一步提升Fabric的管理,其交换功能将获得完全的可组合性。更重要的是,与CXL 2.0一样,CXL 3.0同样完全向下兼容此前的CXL 1.0、CXL 1.1和CXL 2.0标准。

结语

从产品形态来看,CXL为现存的服务器市场带来了不少附加价值,比如一众ASIC加速器、DPU/SmartNIC、重定时器芯片、SSD控制器等。不少厂商都已经看到了这一技术的价值,也已经投入了研发中,或是开始了收购之路。

比如Marvell就在今年5月收购了CXL开发公司Tanzanite Silicon,提高他们在服务器产品上的竞争力。IP厂商Rambus也在同月收购了设计公司Hardent,来补足自己在CXL产品开发上的关键资源。可以预见,随着更多支持CXL的硬件产品推出,这一标准将搅动未来数年的服务器市场。

版权申明:本站文章均来自网络,如有侵权,请联系01056159998 邮箱:itboby@foxmail.com

特别注意:本站所有转载文章言论不代表本站观点,本站所提供的摄影照片,插画,设计作品,如需使用,请与原作者联系,版权归原作者所有